En relisant ces dernières semaines l’excellent Supercade [1] paru aux presses du MIT il y a cela près de 20 ans, je me faisais quelques réflexions sur la technologie et notre relation à celle-ci...

pour poursuivre la lecture de ce billet de blog…

Mais d’abord, pour ceux qui ne connaissent pas l’ouvrage, quelques mots sur Supercade. Abondamment illustré, ce bouquin est un concentré d’histoire des jeux vidéo, couvrant une période allant de 1971 à 1984 et orienté principalement sur le petit monde des salles d’arcade. Très américain dans l’âme, Supercade donne des bouffées de nostalgie à tout ceux qui ont dépensé de l’argent sur Galaxian en attendant leurs parents à la caisse du supermarché ou rêvé devant les écrans de Space Ace à la fête foraine du village. Une enfance biberonnée aux pixels, à une époque où le videogaming n’avait pas encore envahi les maisons, et où les enfants ne passaient pas encore leurs journées de confinement sur la Nintendo Switch ou la PS4 en attendant que leurs parents leur disent de bien finir leurs devoirs. Une époque où les jeux vidéo se consommaient dehors. Nostalgie, donc.

Le livre revient également sur les toutes premières élaborations de jeux sur écran, dans les salles sérieuses des universités américaines : au Laboratoire National de Brookhaven en 1958 et au MIT en 1962. Dans les deux cas, ces premières expérimentations sont le fait de passionnés.

Ce tout petit écran rond, avec les deux manettes de jeu juste en dessous.

Tennis for Two naît en 1958 à Brookhaven dans le cadre des journées portes-ouvertes du laboratoire [2]. L’idée est de démontrer aux visiteurs la puissance et l’attractivité des monstres informatiques qui occupent plusieurs salles des bâtiments, et le meilleur moyen de démontrer tout cela est… la conception d’une démonstration interactive sur écran. Autrement dit, un jeu. Le succès est au rendez-vous est Tennis for Two, une simpliste simulation de tennis sur oscilloscope (pas plus compliquée qu’un bon vieux Pong) devient le clou de la visite pour de nombreuses personnes.

Et vous ne voyez même pas la file d’attente des gamers un peu plus loin.

Autre glorieux vétéran, Spacewar! naît lui au MIT en 1962 dans des circonstances un peu différentes [3]. Les « coupables » sont cette fois les jeunes étudiants du Tech Model Railroad Club [4] du laboratoire, habitués à détourner les outils disponibles ici et là pour améliorer leur réseau de chemin de fer miniature. Littéralement tombés sous le charme d’un nouveau modèle d’ordinateur, ils se mettent au défi de le pousser dans ses retranchements à l’aide d’une démonstration technologique complexe. Quoi de mieux qu’une application interactive pour cela ? Un jeu ? Spacewar!, qui voit s’affronter deux vaisseaux autour d’un trou noir sera – réellement – un défi technologique. Conçu par des chercheurs et des ingénieurs, le jeu respectera le plus scrupuleusement possible les lois de la gravité ou la disposition des étoiles dans le ciel, demandant de multiples optimisations technologiques et informatiques avant d’être présenté à un public plus large. Le jeu aura un succès retentissant dans le milieu universitaire.

Viendra ensuite l’ère des businessmen, le développement des consoles de salon par les fabricants de télévision américains – Magnavox en tête – et la création de la première entreprise entièrement dédiée aux jeux vidéo : Atari. Mais c’est une autre histoire [5].

Cette fois, un peu de Pierre Henry vous mettra dans l’ambiance.

Les premières pages de Supercade nous rappellent surtout que les jeux vidéo sont une invention de technophiles et de passionnés. Des types venus d’une époque où l’informatique était un fantasme qui s’était tout récemment concrétisé en quelques gigantesques armoires de métal. Une époque où le numérique n’avait pas encore envahi le quotidien de tout un chacun et faisait encore l’effet d’une vaste Terra Incognita. Une époque où l’exploitation des données de milliers de personnes par les premiers systèmes IBM n’avait pas encore soulevé de questions quant à notre dépendance aux octets et à l’impact des bases de données sur notre société et nos vies quotidiennes [6].

Supercade rappelle également que ces précurseurs ont été les premiers d’une lignée de passionnés qui ont fondé toute l’industrie des jeux vidéo : des codeurs, pour la plupart, apprenant à maîtriser tous les arcanes d’un processeur, à optimiser les affichages et qui voyaient parfois dans l’art vidéoludique plus qu’un business : un défi technologique et parfois une nouvelle forme d’expression.

Fin de la séquence nostalgie, retour au temps présent !

Nous vivons à la fois une période de techno-hystérie et de techno-doutes.

de notre société actuelle, ne serait-ce pas cette antenne 5G ?

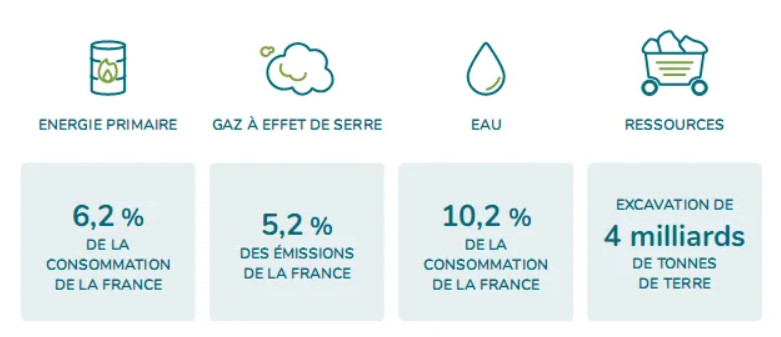

De techno-hystérie car il n’a jamais été autant question de mettre de la technologie partout. Résultat de plus de soixante ans de lune-de-miel informatique, notre société vit dans le numérico-solutionnisme. Nous développons des solutions numériques pour tout : gérer des attestations [7], composter nos déchets [8], reporter les incivilités [9], allumer notre chaudière [10] et bientôt gérer notre conduite automobile en partenariat avec les sociétés d’assurance [11]. Certains – et pas des moindres – étudient même la possibilité de créer des arbres-technologiques destinés à absorber nos excédents de CO₂ [12], caricature s’il en était besoin de là où nous pousse la technologisation à outrance de toute réflexion.

« Oui, il y a une app pour ça aussi ! »

De techno-doutes car, en regard de cette course à la technologie qui rappelle les plus belles inventions du monde cyberpunk [13], les critiques n’ont jamais été aussi nombreuses. Souvent fondées face aux multitudes de projets de vidéosurveillance et de tracking de la population, face à l’emprise des régies publicitaires sur nos vies en ligne [14] et face à l’empire des GAFA sur la société au global [15] – aussi bien économiquement que technologiquement. Les voix se multiplient, les analyses s’affinent et les réflexions évoluent devant ce que les années 2010 nous ont vendu de panacée numérique. Le réveil techno-critique est à comparer au réveil écologique des années 1970 [16], en espérant toutefois son impact bien plus rapide et concret.

comme dans les bonnes vieilles demos des Amiga ?

Cette période critique, charnière et passionnante fait toutefois se poser nombre de question, dont une d’importance : où est passé le rêve ?

Les proto-informaticiens des années 1950 rêvaient de l’ordinateur et de ses applications, tout comme Jules Verne rêvait de l’électricité et des transports émergents. Ils en rêvaient comme rêvent les artisans, concrètement, avec les mains – digitalement – en créant prototypes, expérimentations, démonstrations, monstres et artefacts. Ils ne rêvaient pas de solutions. Spacewar!, pas plus que Pong ou Space Invaders, n’est une réponse à un quelconque problème. Ils rêvaient de possibles. Puisque la technologie existe, il doit être possible de la pousser – gratuitement, sans but – plus loin encore que ce qu’elle ne réalise déjà. Les jeux vidéo, comme beaucoup des fantasmes technologiques d’aujourd’hui, n’ont pas d’objectifs. Ils étaient seulement possibles et on fait rêver des millions de personnes, bousculant à la fois le monde des loisirs, l’industrie balbutiante de l’électronique et de l’informatique et la culture populaire. Une sorte de porte ouverte vers un nouvel univers.

Que sont devenus ces rêves aujourd’hui ?

Rêvez de la technologie n’est plus à la mode… Tout d’abord parce que depuis les années 1990, le monde numérique s’est mâtiné de capitalisme. On n’explore plus les technologies pour le simple plaisir de voir ce qu’elles peuvent faire : on business-plane, on analyse, on solutionne, on start-upise. Le modèle des Business Angels de la Silicon Valley et la mythologie du garage sont passés par là, transformant toute expérience numérique en une culbute potentielle. Nous vivons à l’heure de la Start-up Nation et des investissements : les explorateurs, les poètes, les bénévoles de la technologie se font rares. Les ambitions sont-elles nombreuses

prototype du siège d’Apple ou Facebook ?

Ensuite, devant l’ampleur des empires techniques, on serait tenté de croire que le numérique n’est plus de toutes façons un monde de bricoleur, mais un univers de gigantesques corporations – coucou la Tyrell Corp [17] et l’univers cyberpunk de Blade Runner – et s’il reste des ingénieux capables de concevoir des boîtes à message branchées sur Telegram [18] ou des juke-box magnétiques [19], ce rêve numérique a du plomb dans l’aile. Peut-être parce qu’il a dévoilé trop de ses côtés obscurs – sociétaux, écologiques, cognitifs… et peut-être qu’après une période d’enchantement vient toujours la période des désillusions ? Peut-être un peu parce que le monde digital est également une cible facile en ces temps de crise – sanitaire, écologique, économique… – et que quitte à interdire aux enfants de rêver d’avions, on pourrait également leur interdire de rêver de robots ?

Rêvons-nous encore de moutons électriques ?

Les technophiles des années soixante, les chercheurs et les industriels qui travaillaient et découvraient les possibilités des gigantesques systèmes informatiques des universités et laboratoires d’état, ont donné naissance – pas tout à fait malgré eux – à une contre-culture solide qui a irrigué le monde. Plus artistique, plus libre, et quelque part plus responsable, la vague hippie des années 1970 est apparue en partie en réaction à l’American Way of Life et à la débauche d’écrans – de télévision – de l’Amérique moyenne. Et comme rien n’est jamais simple, elle a également joué de ses moyens technologiques pour diffuser son idéal, faire bouger les lignes et faire résonner ses revendications. Les écrans des networks établis sont également devenus les mégaphones de la contre-culture, les supports d’expérimentation des artistes des années soixante et soixante-dix. La technologie est devenue moyen de militantisme, arme de changement. Bien entendu, l’histoire est plus compliquée que cela.

Aujourd’hui, nos rêves se nourrissent d’autres idées. Des idées qui, sans exclure les outils technologiques, ne leur donnent plus forcément la part dominante. On parle du recyclage de la ville [20], on parle de créer de nouvelle mobilité, on parle de préserver l’anonymat sur le Net [21], on parle de révolutionner le monde de l’habillement et de laisser disparaître l’écologiquement désastreuse mode du Fast-Fashion [22], on parle aussi et surtout d’adapter nos innovations aux défis écologiques et sociétaux auxquels nous devons faire face sans pour autant tout sacrifier à la technologie.

Il est difficile de sortir de plus de cent-vingt ans de culte de la machine. Mais sans parler de retourner à l’ère de Amish – on ne l’a jamais réellement envisagé, l’imaginer est une caricature politique [23] – il est difficile de nier que nos rêves sont en train de changer, et que la pandémie globale de Covid-19 qui fait danser l’humanité depuis plus d’un an a sans doute accéléré la valse de nos envies.

Le parallèle est tentant. Vingt ans après la première bulle du Net et après plus d’une dizaine d’années de techno-culte, ne sommes-nous pas en train de construire une nouvelle contre-culture sur le lit des réseaux sociaux et des technologies ouvertes ?

L’urbanisme circulaire n’est-il pas notre nouveau rêve de communauté ? La lutte contre la surveillance est-elle une nouvelle forme du refus de l’emprise administrative ?

Si le contexte s’est globalisé et concerne désormais le monde entier, et chacun d’entre nous, si l’urgence écologique est autrement plus urgente qu’elle ne l’était il y a cinquante ans, les parallèles sont troublants et la répétition d’un cycle d’action-réaction est flagrant. Loin des nouveaux amish, nous sommes peut-être les nouveaux hippies. Des hippies que ne nient pas l’apport de la technologie, qui en jouent et savent – parfois – en éviter les abus. Et qui veulent cette fois, au lieu de simplement l’explorer, en connaître les limites « humaines » et réfléchir à ses apports réels à la société.

Les créateurs de Tennis for Two et de Spacewar! rêvaient de technologie pure et voulaient pousser les machines dans leurs retranchements. Ils se voyaient en explorateurs d’un nouveau monde technologique. La génération qui a construit le Net des années 2000 est sans doute la dernière à avoir partagé ce rêve technologique pur.

Quel symbole pour celles d’aujourd’hui ?

Aujourd’hui, nos imaginaires et nos ambitions ont besoin de se transformer.

En soixante ans, nous avons vu ce dont était capable la technologie et les dérives auxquelles elle pouvait mener. Nous maîtrisons les ordinateurs, mais il nous manque sans doute la sagesse de maîtriser l’usage que nous en faisons. Ne plus faire la technologie pour la technologie, passer le cap, voilà le défi que les nouveaux hippies ont besoin de relever. Redonner à l’homme une place centrale dans la révolution numérique, redonner à la Terre une place centrale également et continuer à construire des outils et des imaginaires qui servent ce recentrage.

Aujourd’hui, nos imaginaires ne sont sans doute plus ceux d’explorateurs. Noyés dans la technologie, nous rêvons d’une façon de ré-habiter le monde – et pourquoi pas avec l’aide des machines quand celles-ci sont positives, responsables et non-aliénantes.

Reste une bonne nouvelle : c’est que nous rêvons toujours.